嗨,大家好,前几天OpenAI发布的GPT-o1大家都用上了嘛,体验下来怎么样?给我的感觉这个模型不太适合通用问题,比较适合推理性强的数学题以及一些逻辑性强和思维链有关的问题,对于搞科研或者开发者来说是非常友好的。好了,言归正传,今天分享一个震撼游戏界的项目,如果你是个爱玩游戏的同好,这个项目将来可能会改变玩游戏的方式。这是一个由香港科技大学、中国科学技术大学和腾讯LightSpped Studio联合研发的生成式开放世界游戏模型。

我们先来看一段致敬黑神话-悟空的Demo视频:

GameGen-O 概述

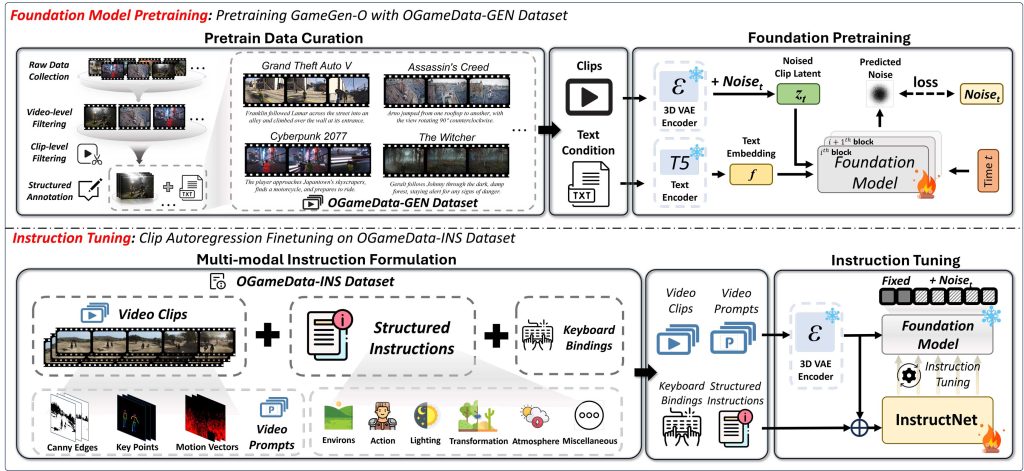

这是首个专为生成开放世界视频游戏而设计的扩散变换器模型。通过模拟广泛的游戏引擎特性,如创新角色、动态环境、复杂动作和多样事件,该模型实现了高质量、开放世界的生成。此外,它还提供了交互式可控性,从而允许游戏玩法模拟。 GameGen-O 的开发涉及从0开始的全面数据收集和处理工作。收集并构建了首个开放世界游戏数据集(OGameData),从100多个次世代开放世界游戏中收集了大量数据,并使用专有数据通道进行高效分类、评分、筛选和解耦注释。这个强大而广泛的 OGameData 构成了模型训练过程的基础。

GameGen-O 经历了两阶段训练过程,包括基础模型预训练和指令微调。在第一阶段,模型通过文本到视频和视频延续在 OGameData 上进行预训练,赋予 GameGen-O 开放世界游戏生成能力。在第二阶段,预训练模型被冻结,使用可训练的 InstructNet 进行微调,使其能够基于多模态结构指令生成后续帧。这整个训练过程赋予了模型生成和交互控制内容的能力。

特点

- 高质量、开放域生成: 能够生成创新角色、动态环境、复杂动作和多样事件。

- 交互式可控性: 允许实时游戏玩法模拟和内容控制。

- 大规模数据集: 基于自建的 OGameData,包含来自100多个次世代开放世界游戏的数据。

- 多模态结构指令: 通过 InstructNet 实现基于多种模态输入的精确控制。

这个模型的独特之处在于它能够创造出丰富多样的游戏元素,从角色和环境到动作和事件,都能以一种连贯和可控的方式生成。

核心技术

1. 扩散变换器模型

GameGen-O 的核心是一个扩散变换器模型,结合了扩散模型的生成能力和 Transformer 架构的序列建模能力。

2. 3D VAE (变分自编码器)

为了有效处理视频数据,GameGen-O 采用了 3D VAE:

- 用于压缩视频片段

- 进行了游戏领域特定的适应

3. 混合训练策略

模型采用了创新的混合训练策略:

- 基础模型预训练和指令微调两阶段训练

- 使用噪声注入技术增强模型鲁棒性

模型架构

GameGen-O 的架构可以分为两个主要部分:

- Video DiT Foundation Model

- 包含多个时空DiT块,用于处理视频数据

- 使用Layer Norm、Self-attention和Cross-attention等技术

Video DiT Foundation Model是GameGen-O中负责视频生成的核心组件。它基于扩散变换器(Diffusion Transformer)架构,专门设计用于处理和生成高质量的视频游戏内容。

- InstructNet

- 包含多个时空块,用于处理指令和操作提示

- 使用zero linear技术进行模块间连接

InstructNet是GameGen-O模型中负责处理多模态指令和实现交互控制的关键组件。它的设计目的是将用户的指令(文字提示、按键操作提示)精确地转化为视频生成过程的控制信号。

OGameData: 模型的训练基础

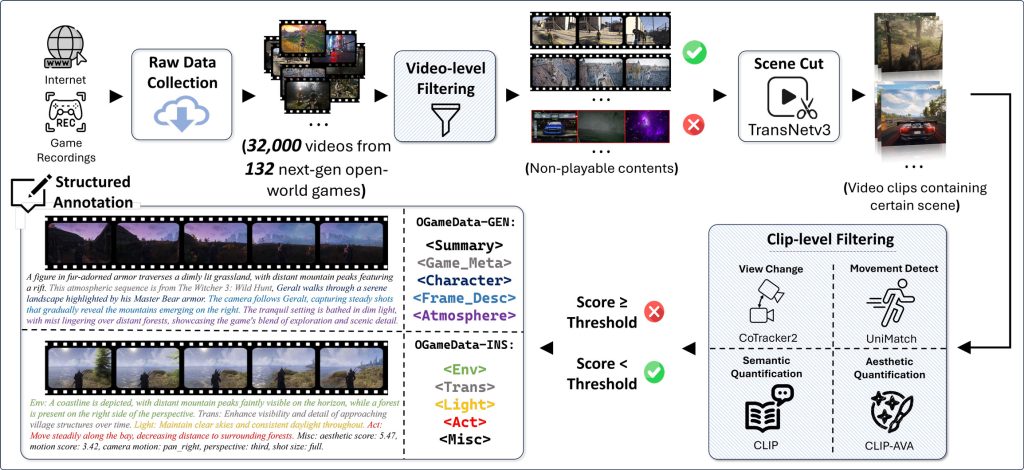

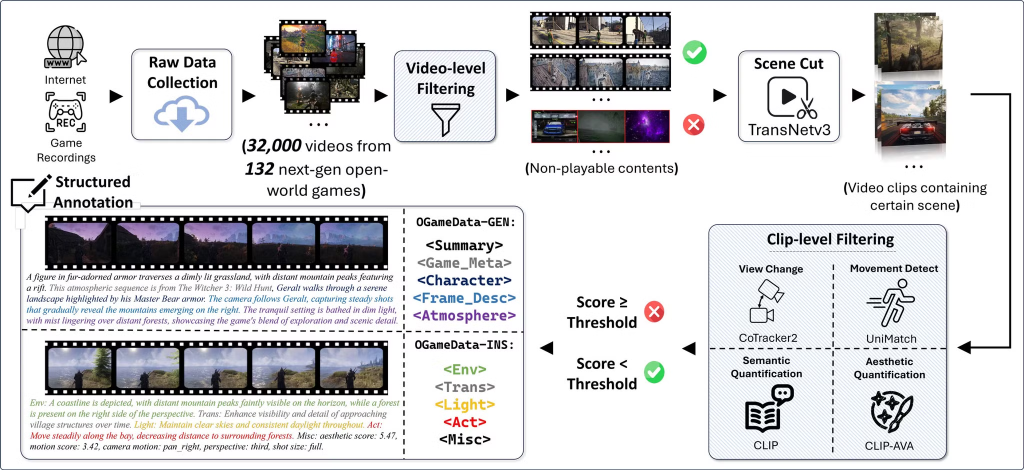

大家都知道,一个可运行的模型基于算力、算法、数据,那这个GameGen-O 同样也离不开数据。 OGameData这个数据集的特点包括:

- 来自 132 个次世代开放世界游戏的 32,000 个视频

- 经过严格的筛选和注释流程

- 包含两个子集:OGameData-GEN 和 OGameData-INS

数据处理流程:

- 原始数据收集 (从互联网和游戏录制)

- 视频级过滤 (去除不可玩内容)

- 场景切割 (使用 TransNetv3)

[技术: 视频分割] - 片段级过滤,包括:

- 视角变化检测 (使用 CoTracker2)

[技术: 运动追踪] - 运动检测 (使用 UniMatch)

[技术: 运动分析] - 语义量化 (使用 CLIP)

[技术: 视觉-语言预训练模型] - 美学量化 (使用 CLIP-AVA)

[技术: 美学评估]

- 视角变化检测 (使用 CoTracker2)

- 结构化注释

[技术: 自动化标注, 多模态对齐]

训练过程

GameGen-O 的训练分为两个主要阶段:

1. 基础模型预训练 [技术: 自监督学习, 预训练]

- 使用 OGameData-GEN 数据集

- 结合视频片段和文本条件进行训练

- 使用 3D VAE 编码器压缩视频

- 应用噪声注入技术增强模型鲁棒性

2. 指令微调 [技术: 指令学习, 微调]

- 使用 OGameData-INS 数据集

- 融合视频片段、结构化指令和键盘绑定信息

- 固定基础模型权重,只训练 InstructNet

- 实现多模态指令的精确控制

创新点

- 多模态指令控制: 通过 InstructNet 实现视频、文本和操作的融合控制

[技术: 多模态融合] - 时空 DiT 架构: 专为视频生成设计的扩散变换器结构

[技术: 时空建模] - 大规模游戏数据集: OGameData 为模型提供了丰富的训练资源

[技术: 大规模数据集] - 两阶段训练策略: 基础预训练加指令微调,提高模型的生成能力和可控性

[技术: 迁移学习]

应用前景

GameGen-O 在游戏开发领域有着广泛的应用潜力:

AI辅助设计: 与人类设计师协作,提供创意灵感 [技术: 人机协作, 创意AI]

快速原型开发: 游戏设计师可以快速生成和可视化游戏概念 [技术: 快速原型生成]

内容生成: 自动生成大量多样化的游戏内容,如地形、建筑和NPC [技术: 程序化内容生成]

交互式故事创作: 基于玩家选择动态生成游戏剧情 [技术: 动态故事生成, 自适应游戏设计]

生成的游戏示例:

- 生成的角色

2. 生成的环境

3. 生成的人物操作

4. 生成的事件

5. 生成的开放场景

更多视频可以在gamegen-o博客文章观看。

OGameDataDemo

Environmental Basics: Show a lush, green countryside path lined with stone walls and trees under a sunset sky. Main Character: Have the main character riding steadily forward on horseback along the path. Environmental Changes: Slowly move the horse and rider deeper into the scene along the path. Sky/Lighting: Maintain consistent golden sunset lighting throughout. aesthetic score: 5.54, motion score: 8.45, camera motion: zoom_in, perspective: third, shot size: full.

环境基础知识:在日落的天空下展示一条郁郁葱葱的绿色乡村小径,两旁是石墙和树木。主角:让主角沿着小路骑马稳步前进。环境变化:沿着路径慢慢地将马和骑手移动到场景中的更深处。Sky/Lighting(天空/照明):始终保持一致的金色日落照明。美学得分:5.54,运动得分:8.45,摄像机运动:zoom_in,透视:第三,镜头尺寸:完整。

写在最后

好了,以上便是GameGen-O模型的整体介绍,该团队提到了即将发布开源版本的OGameData数据集。你对GameGen-O有什么看法?你认为它会如何改变游戏开发的未来?欢迎在加入微信公众号分享你的想法!