Meta发布Llama3.2啦!还记得扎克伯格说过:“我们的模型还太大了,不够小。“这不,适合移动端和边缘计算的版本来了,虽然这次发布的llama3.2-1B和3B是llama3.1的剪枝版本,但是丝毫不影响其性能。不仅发布了1B和3B轻量级语言模型,Llama系列终于迎来了多模态视觉模型llama3.2-11B-Vision和llama3.2-90B-Vision,Meta用这两个模型在基准测试上拿闭源的Claude3-haiku和GPT-4O-mini做了对比测试,评分几乎不相上下,甚至有些指标还挺高。那么,接下来我们一起了解下这些模型吧!

Llama 3.2系列模型重大升级简介

这次Llama 3.2的升级可以说是很有看头的。来,我给大家捋一捋主要亮点:

- 推出了四个全新模型:Llama 3.2 1B、3B和Llama 3.2-Vision 11B、90B

- 1B和3B模型专注于多语言文本处理,适合轻量级应用

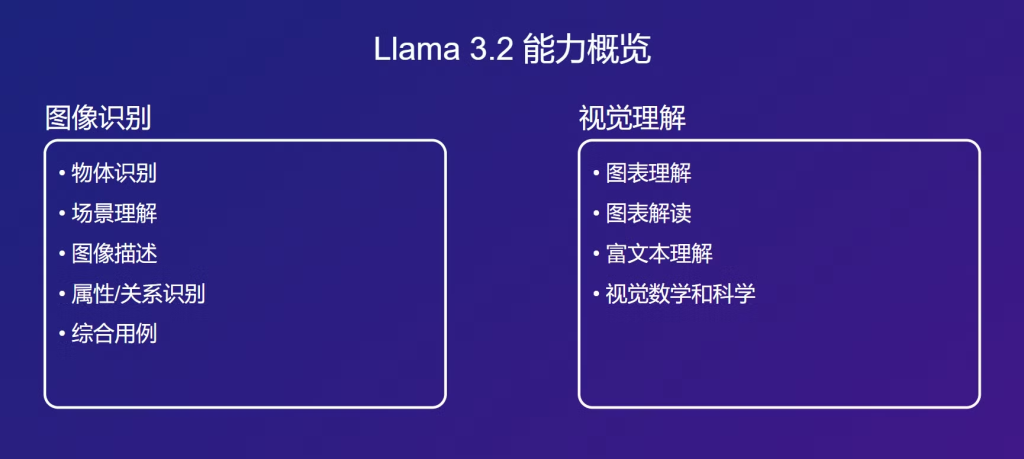

- 11B和90B模型则支持图像和文本输入,可以进行视觉识别、图像推理等任务

- 上下文长度提升到了128K tokens,这可是相当长的记忆力啊;

- 在多个评测基准上又刷新了记录,表现相当亮眼

- 知识截止日期更新到2023年12月,信息更新更及时

模型基础信息

来,咱们先来了解一下Llama 3.2-Vision模型的基本情况:

| 模型 | 参数量(B) | 输入模态 | 输出模态 | 上下文长度 | 是否支持GQA | 知识截止日期 |

|---|---|---|---|---|---|---|

| Llama 3.2 1B | 1.23 | 多语言文本 | 多语言文本和代码 | 128K | 是 | 2023年12月 |

| Llama 3.2 3B | 3.21 | 多语言文本 | 多语言文本和代码 | 128K | 是 | 2023年12月 |

| Llama 3.2-Vision 11B | 11 | 图像+文本 | 文本 | 128K | 是 | 2023年12月 |

| Llama 3.2-Vision 90B | 90 | 图像+文本 | 文本 | 128K | 是 | 2023年12月 |

训练数据与方法

Meta这次在训练数据上可是下了大功夫。1B和3B模型用了高达9万亿tokens的预训练数据,而Vision模型则使用了60亿的图像-文本对。这数据量可真是够大的。 有意思的是,1B和3B模型在预训练阶段还用到了知识蒸馏技术。它们借鉴了Llama 3.1中8B和70B模型的输出,这招挺高明的,让小模型也能学到大模型的”精华”。

硬件与软件

说到训练,他们用上了自家的定制GPU集群和生产基础设施。光是训练就用了超过200万GPU小时的计算资源,这算力投入真是够大的。

不过Meta倒是很注重环保,他们声称整个训练过程实现了净零温室气体排放。这种对环境负责的做法值得点赞!

多语言能力

Llama 3.2在语言能力方面表现出色。官方支持英语、德语、法语、意大利语、葡萄牙语、印地语、西班牙语和泰语这8种语言,实测下来对于中文的输出能力很一般,这时候就需要借助开源社区的力量了。虽然Llama 3.2-Vision主打的是视觉理解能力,但它在语言方面的理解能力也是非常优秀。不过在图像+文本的多模态任务中,目前只支持英语输入。

Llama 3.2-Vision模型的能力展示

Meta这次可是下了不少功夫来展示Llama 3.2-Vision的实力。我们来看看它在各个方面的表现:

图像理解能力

在VQAv2验证集上,Llama 3.2-Vision 90B模型获得了73.6%的准确率,11B版本也达到了66.8%。这个成绩在开源模型中可以说是相当不错了。

在文档视觉问答(DocVQA)任务上,90B版本的ANLS(平均归一化最小编辑距离得分)高达70.7%,这足以显示出它对文档图像的强大理解能力。

视觉推理能力

在MMMU(多模态统一评估基准)的零样本测试中,90B版本取得了49.3%的微平均准确率。虽然不及GPT-4,但在开源模型中已经很出色了。

对于图表问答(ChartQA),90B版本的准确率达到54.2%,在理解和分析复杂图表方面展现出不俗的实力。

指令调优后的表现

经过指令微调后,Llama 3.2-Vision的能力又上了一个台阶:

- 在MMMU的思维链(CoT)测试中,90B版本达到了60.3%的微平均准确率

- 在ChartQA测试中,采用思维链方法后,90B版本的松弛准确率高达85.5%

- 在VQAv2测试集上,90B版本的准确率提升到了78.1%

这些数据充分说明,Llama 3.2-Vision在图像理解、视觉推理等方面的能力已经相当强大了。

llama3.2模型架构图的工作原理:

首先,用户给模型输入一张图和文字,模型会先做两件事:1. 把文字转变成一串数字,这样电脑更容易理解;2. 用特殊的”看图软件”(就是那个Vision Encoder)把图片转变成一堆数字。然后模型就开始和这堆数字做信息交互了,交互层有很多,有些层是专门处理文字的,有些层是专门处理图片和文字的(就是Cross Attention Layer)。这些信息在层之间来回传递交互,每经过一层”Cross Attention”,文字信息就会和图片信息碰个面,,换一下情报。这样,模型就能逐渐理解图片里有什么,以及这些东西和文字有什么关系。当所有信息都处理完了,顶层的”Text Layer”就会输出结果。这个结果可能是对你问题的回答,也可能是对图片的描述,全看你一开始要求它做什么。

Llama 3.2的亮点特性

除了impressive的基准测试成绩,Llama 3.2还有一些很吸引人的特性:

超长上下文处理能力

所有Llama 3.2模型都支持128K tokens的超长上下文,这在处理长文档、复杂对话时可是帮了大忙了。最让人惊讶的是,即使是1B和3B这样的小模型也能支持这么长的上下文,这在目前可是很少见的。

安全性考虑

Meta在开发Llama 3.2时也很注重安全性。他们采取了多项措施来增强模型的安全性,包括:

- 开发了专门的对抗性评估数据集;

- 结合Purple Llama安全工具来过滤输入和输出;

- 进行了多轮的红队测试,模拟各种潜在的滥用场景;

这些措施都是为了让Llama 3.2在强大的同时,也能更加安全可控。

如何使用Llama 3.2

- 直接从Meta的GitHub仓库下载模型权重;

- 使用Hugging Face Transformers库加载模型;

- 国内的魔搭社区使用modelscope库下载模型权重;

- Ollama_v0.3.12支持Llama 3.2-1B和3B。

Meta还提供了详细的使用文档和示例代码,帮助开发者快速上手。不过要注意,目前的Llama 3.2-Vision-11B还是全精度版本,单块消费级显卡完全跑不动,亲测,生成速度巨慢。

huggingface:https://huggingface.co/meta-llama

GitHub:https://github.com/meta-llama

魔搭社区:https://modelscope.cn/organization/LLM-Research?tab=model