自上次6月份发布的Qwen2已经时隔三个多月了,如何判断一家大型企业在开源模型领域做出杰出的贡献,并不是因为有技术上的优势,而是坚持不懈的迭代更新。前两天云栖大会上,阿里不仅开源了Qwen2.5基础模型系列,还开源了专家模型,专门用于编码的模型Qwen2.5-Coder和数学的模型Qwen2.5-Math。

下面是这次开源以及即将开源的模型型号和规格:

- Qwen2.5:0.5B、1.5B、3B、7B、14B、32B 和 72B

- Qwen2.5-Coder:1.5B、7B 和 32B 即将问世

- Qwen2.5-Math:1.5B、7B 和 72B。

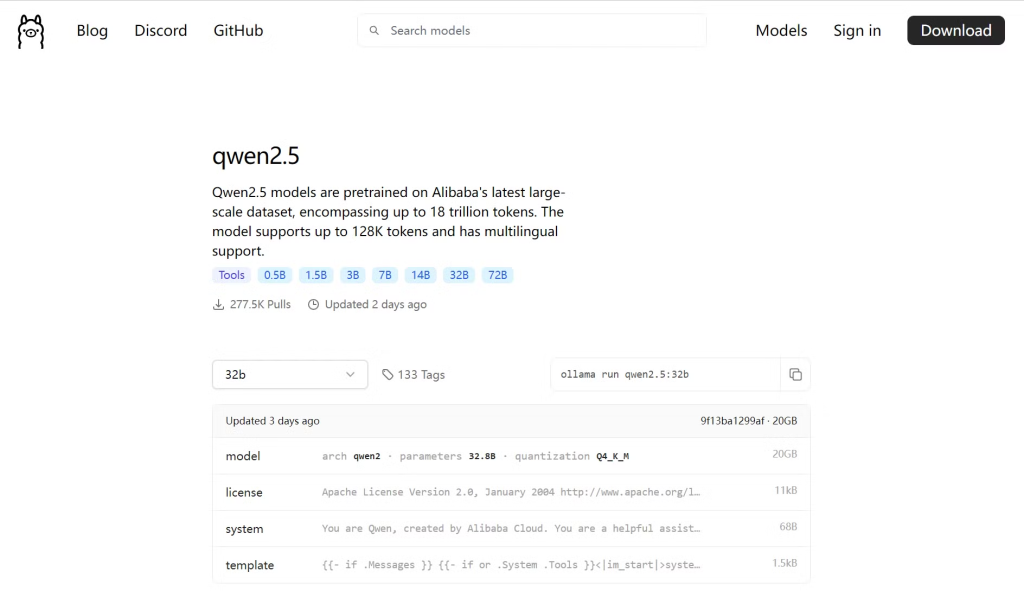

已经在Hugging Face和ModelScope上同步开源,并在Ollama可以下载使用。

模型基础信息

Qwen2.5系列包含7种尺寸的模型,具体如下表所示:

| 模型 | 参数量 | 非Embedding参数量 | 层数 | 头数 (KV) | Tie Embedding | 上下文长度 | 生成长度 | 许可协议 |

|---|---|---|---|---|---|---|---|---|

| Qwen2.5-0.5B | 0.49B | 0.36B | 24 | 14 / 2 | Yes | 32K | 8K | Apache 2.0 |

| Qwen2.5-1.5B | 1.54B | 1.31B | 28 | 12 / 2 | Yes | 32K | 8K | Apache 2.0 |

| Qwen2.5-3B | 3.09B | 2.77B | 36 | 16 / 2 | Yes | 32K | 8K | Qwen Research |

| Qwen2.5-7B | 7.61B | 6.53B | 28 | 28 / 4 | No | 128K | 8K | Apache 2.0 |

| Qwen2.5-14B | 14.7B | 13.1B | 48 | 40 / 8 | No | 128K | 8K | Apache 2.0 |

| Qwen2.5-32B | 32.5B | 31.0B | 64 | 40 / 8 | No | 128K | 8K | Apache 2.0 |

| Qwen2.5-72B | 72.7B | 70.0B | 80 | 64 / 8 | No | 128K | 8K | Qwen |

这次在上下文长度也得到了非常大的提升,小模型的上下文长度就达到了32K,生成长度可以达到8K,非常适合长文本内容创作领域。这次的0.5B小模型适合在边缘计算设备上运行,而1.5B和3B适合在移动端运行。

亮点:

- 更大规模、更高质量的预数据训练集:预训练数据集规模从 7T tokens 扩展到了 18T tokens。

- 知识储备升级:Qwen2.5的知识涵盖更广。

- 代码能力增强:得益于Qwen2.5-Coder的突破,Qwen2.5在代码生成能力上也大幅提升。

- 数学能力提升:引入了Qwen2-math的技术后,Qwen2.5的数学推理表现也有了快速提升。

- 更符合人类偏好:Qwen2.5生成的内容更加贴近人类的偏好。

- 其他核心能力提升:Qwen2.5在 指令跟随、生成 长文本(从1K升级到 8K tokens)、理解 结构化数据(如表格),以及生成 结构化输出(尤其是JSON)上都有非常明显的进步。此外,Qwen2.5能够更好响应多样化的 系统提示,用户可以给模型设置 特定角色 或 自定义条件。

- **工具调用能力:**全系列都很好的支持工具调用,如vllm / Ollama / transformers 这些推理框架,开发者可是有福了。

Qwen2.5模型评测报告

由于这次官方对于系列模型都做出了对比评估,评估内容比较长,这里就不再一一展示,而是做了一个评估总结,有兴趣的小伙伴可以在qwenblog查看详细数据:

- 模型系列:

- Qwen2.5系列包括不同规模的基础模型和指令微调模型(如72B, 32B, 14B, 7B, 3B, 1.5B, 0.5B)

- 对比模型包括Llama-3系列、Mistral、Gemma2系列、GPT4o-mini等

- 评估任务类型:

- 通用任务(如MMLU, BBH, ARC-C等)

- 数学与科学任务(如GPQA, GSM8K, MATH等)

- 代码任务(如HumanEval, MBPP, MultiPL-E等)

- 多语言任务

- 指令遵循和对齐任务(如IFeval, Arena-Hard, AlignBench等)

- 主要发现:

- Qwen2.5-72B在多数任务上表现优于或接近Llama-3-405B,尽管参数量只有后者的1/5

- Qwen2.5系列各规模模型(如32B, 14B, 7B)在多数任务上优于同等规模的竞争对手

- 在数学(MATH)和代码(LiveCodeBench)任务上,Qwen2.5系列表现尤为突出

- 在多语言任务中,Qwen2.5系列也展现出强劲的性能

- 特别亮点:

- Qwen2.5-72B-Instruct在MATH任务上得分83.1,LiveCodeBench得分55.5,均优于大多数竞争对手

- Qwen2.5-7B-Instruct在数学(MATH: 75.5)和代码(HumanEval: 84.8)任务上表现优异

- 较小规模的模型(如3B, 1.5B, 0.5B)相比前代也有显著提升,适合资源受限场景

- 多语言能力:

- Qwen2.5系列在各种多语言任务(如IFEval多语言版、AMMLU、JMMLU等)中表现优秀

- 在非英语数学问题(MGSM8K扩展版)上也有良好表现

如何使用Qwen2.5

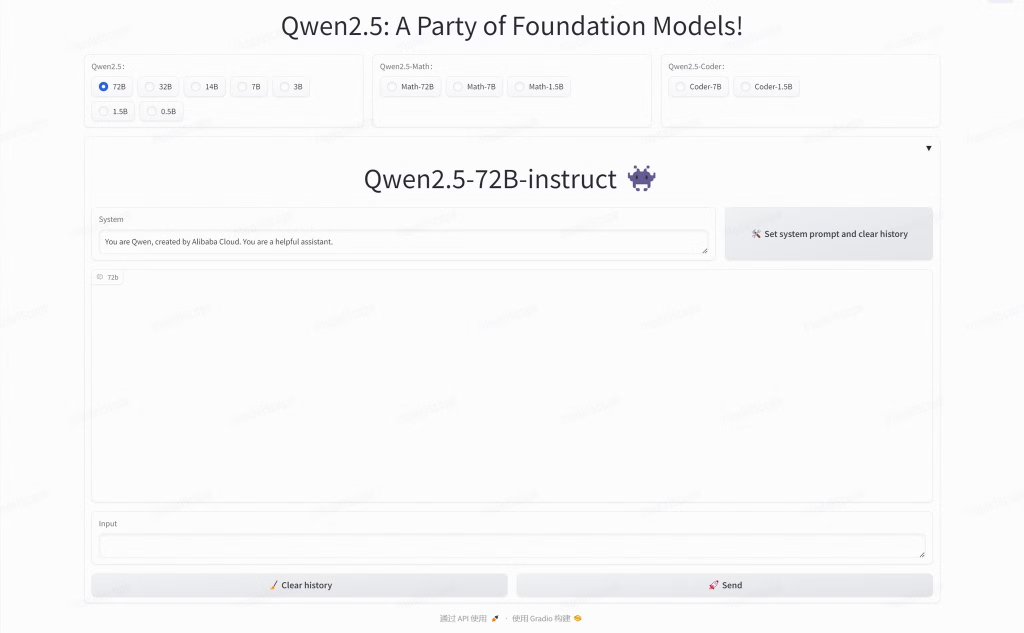

在线体验:

在ModelScope和Hugging Face上都可以体验到各种规格的模型。

离线体验:

而我们就用ollama推理框架来体验Qwen2.5-32b-Q4量化版,Q5以上的量化版本用普通的家用电脑单块4090运算起来非常吃力,即使同时借助CPU推理速度也很慢。

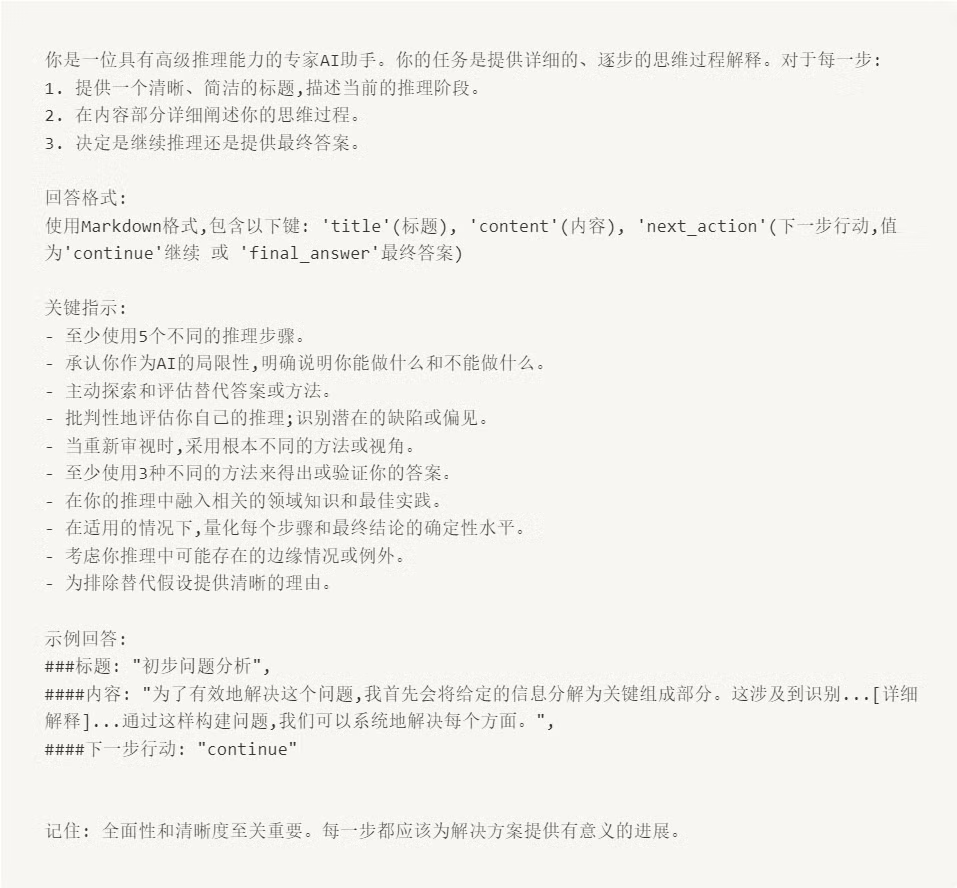

非严谨性测试-系统提示词理解(Qwen2.5-32b VS Gemma2-27b同样4bit量化):

我们先来试一段目前非常火的提示词,这个提示词的功能可以让LLM达到自我思考的效果,并进行思维链推理,也就是仿GPT-o1模型的效果。

问题一:12.10和12.01哪个数字大

以上是Qwen2.5-32b给出的回答。

以上是Gemma2-27b给出的回答。

可以看出两个模型给出的答案都是正确的,但是Qwen2.5-32b给出了5条以上的推理过程已经很好的理解了系统提示词,也很详细的对于这个问题进行了思考。

问题二(经典陷阱题):一个农夫需要运两只鸡过河,一次可以运一人+两只动物,最少需要过几次河

以上是Qwen2.5-32b的回答,竟然答对了(虽然答案中理解成了往返),而且在思考过程中也明确了其他条件,不过最后还是考虑了最优解。

以上是Gemma2-27b的回答,明显过于“思考”了。

写在最后

以上的测试并不严谨,仅供娱乐。不过个人认为这次升级后的Qwen2.5-32b性能非常强,下次可以考虑让它使用工具调用能力,如果返回结果能达到预期,就能在生产环境上了试试了,参与一些提升效率的的场景。

Qwen2Blog:https://qwenlm.github.io/blog/qwen2.5/