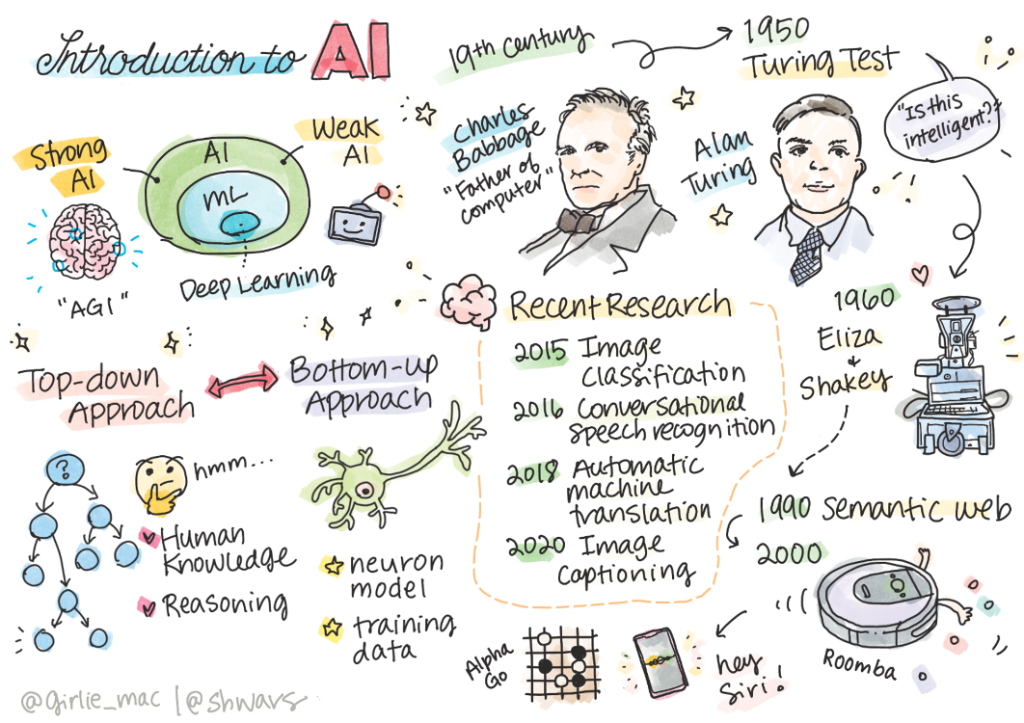

人工智能简介(人工智能的介绍和历史)

开篇

人工智能是一门激动人心的科学学科,研究我们如何让计算机展现出智能行为,例如:做那些人类擅长做的事情。

最初,计算机是由查尔斯·巴贝奇(Charles Babbage)发明的,用于按照一个明确定义的过程——即算法来操作数字。现代计算机虽然比19世纪提出的原始模型先进得多,但仍然遵循相同的控制计算理念。因此,如果我们知道了为了达到目标所需执行的确切步骤序列,就可以编程让计算机去做某件事。

摄影师:Vickie Soshnikova

✅ 从某人的照片定义其年龄是一项意义不明的编程任务,因为我们不知道当这样做时,是如何想象出一个数字的。

然而,有些事情,即使是最先进的计算机,也难以做到。比如,看一眼照片,就能判断出一个人的年龄。我们人类能够做到这一点,是因为我们的大脑中,已经存储了无数张不同年龄的面孔。这些面孔,在我们的潜意识中,形成了一种模式,帮助我们做出判断。但这种直觉,这种隐晦的推理过程,却难以用代码和逻辑来表达,难以直接编程实现。

所以,人工智能,它就像是个勤学苦练的学生,不断地学习,不断地思考,最终才能做到像咱们人类一样,看一张照片,就能猜出个八九不离十。这门学问,可真是深奥,但也充满了乐趣,因为它让机器能像人一样思考,能做人类能做的事情。

✅ 想想你可以将哪些任务外包给计算机,这些任务将从AI中受益。考虑金融、医学和艺术领域——这些领域今天是如何从AI中受益的?

| 弱人工智能 | 强人工智能 |

|---|---|

| 弱人工智能是指为特定任务或一组狭窄的任务设计和训练的人工智能系统。 | 强人工智能,或通用人工智能(AGI),是指具有人类水平的智能和理解的人工智能系统。 |

| 这些人工智能系统通常不是智能的;他们擅长执行预定义的任务,但缺乏真正的理解或意识。 | 这些人工智能系统能够执行人类可以完成的任何智力任务,适应不同的领域,并拥有某种形式的意识或自我意识。 |

| 弱人工智能的例子包括 Siri 或 Alexa 等虚拟助手、流媒体服务使用的推荐算法以及专为特定客户服务任务设计的聊天机器人。 | 实现强人工智能是人工智能研究的长期目标,需要开发能够在各种任务和环境中推理、学习、理解和适应的人工智能系统。 |

| 弱人工智能是高度专业化的,不具备类似人类的认知能力或超出其狭隘领域的一般问题解决能力。 | 强人工智能目前是一个理论概念,没有一个人工智能系统达到这种通用智能水平 |

智能的定义和图灵测试

要给“智能(Intelligence)”这个词下一个确切的定义非常难,因为这个词没有明确的定义。有人可能会认为智能与抽象思维或自我意识有关,但我们无法恰当地定义它。

Unsplash 上的 Amber Kipp 拍摄的图片

“智能(Intelligence)”一词,它的界限模糊,若问:“一只猫是否聪明?”这个问题的答案,便如同那些人性中的善与恶,美与丑,难以用简单的是与非来界定。不同的人,会根据自己的观察和经验,给出不同的答案。有人可能会被猫的敏捷和机智所折服,认为它们聪明过人;而另一些人,则可能因为猫的独立和难以预测的行为,而认为它们难以捉摸。然而,要找到一个被所有人接受的标准来衡量猫的智能,却是一项几乎不可能完成的任务。如果你坚持认为存在某种智商测试能够证明猫的智能,那么,不妨试着让你的猫来通过这样的测试。但你会发现,猫的天性并不适合这种测试。它们可能会在测试中展现出某些惊人的能力,但也可能完全无视这些测试,只按照自己的意愿行事。

✅ 花一分钟时间思考你如何定义智能。一只能够在迷宫中获得食物的乌鸦聪明吗?一个孩子聪明吗?

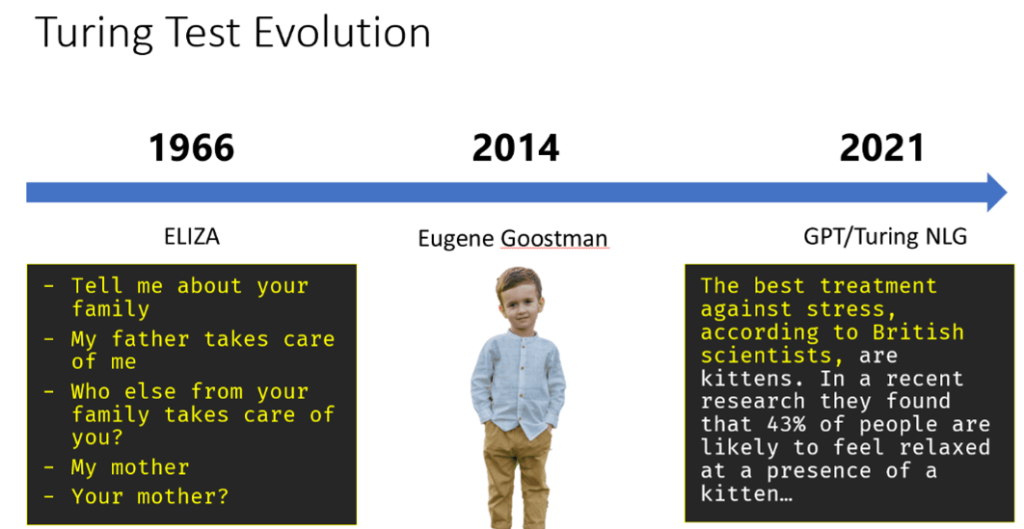

在探讨人工通用智能(AGI)的领域,我们面临着一个关键的挑战:如何判断我们所创造的系统是否真正具备智能。艾伦·图灵(Alan Turing),这位计算机科学的先驱,提出了一种独特的测试方法——图灵测试,它在某种程度上为智能提供了一种衡量标准。

图灵测试的核心思想在于比较。它将一个未知的系统与一个具有智能的真实人类进行对比。为了避免计算机程序通过自动化手段进行欺骗,测试采用了“人类审讯者”的角色。这位“审讯者”通过基于文本的对话,试图辨别出对话的另一方是人类还是计算机系统。如果审讯者无法做出区分,那么该系统便被认为具有智能。

在2014年,一个名为尤金·古斯特曼(Eugene Goostman)的聊天机器人,以其巧妙的个性设定,几乎成功地通过了图灵测试。它自称为一个13岁的乌克兰男孩,这个设定巧妙地解释了其在知识上的不足以及对话中的某些差异。通过这一策略,尤金·古斯特曼在5分钟的对话后,成功说服了30%的评委相信它是人类。这一比例,正符合图灵所预测的机器在2000年能够达到的智能水平。然而,这一结果并不意味着我们已经成功创造了一个真正智能的系统。它也不应被解读为计算机系统欺骗了”人类审讯者“。实际上,这里并没有发生欺骗,而是机器人的创造者通过巧妙的设计,引导了“人类审讯者”的判断。这一事件提醒我们,智能的判断并非总是直接和明确的,它可能受到多种因素的影响,包括我们对智能的预期、对话的背景和上下文,以及我们对机器能力的假设。

✅ 你有没有被聊天机器人愚弄过,以为你在和人类说话?它是怎么说服你的?

不同的AI方法

若我们期望计算机能如人类般行动,那么必须在计算机内部模拟出我们思维的机制。因此,我们首先需要深入探究,究竟是什么赋予了人类智慧的光芒。

在机器的世界里,要教它们如何思考,我们得先搞清楚自己是如何做决定的。就像村里的老人,他们不用看天,就知道明天会不会下雨,那是他们几十年经验的直觉。而我们呢,有时候,就像看到一只猫和一只狗,我们几乎不用想,就能立刻分辨出来。但有时候,我们得像老牛拉犁一样,一步步地推理,才能得出结论。

这个问题有两种可能的方法:

| 自上而下的方法(符号推理) | 自下而上的方法(神经网络) |

|---|---|

| 用自上而下的方法模拟一个人类解决问题的推理方式。它涉及从人类那里提取知识,并以计算机可读的形式表示。我们还需要开发一种在计算机内模拟推理的方法。 | 用自下而上的方法模拟人脑的结构,由大量的简单单元组成,称为神经元。每个神经元就像其输入的加权平均值,我们可以通过提供训练数据,来训练神经元网络解决有用的问题。 |

还有其他一些可能的智能方法:

- 一种新兴的、协同的或多智能体(multi-agent )的方法是基于这样一个事实,即通过大量简单智能体的交互可以获得复杂的智能行为。根据进化控制论,智能可以从更简单的、反应性的行为中在元系统转换的过程中出现。

- 一种进化方法,或遗传算法是基于进化原理的优化过程。

我们将在课程后面考虑这些方法,但现在我们将专注于两个主要方向:自上而下和自下而上。

自上而下的方法(The Top-Down Approach)

在自上而下的方法中,我们尝试模拟推理。因为我们可以在推理时跟随我们的思维,可以尝试将这个过程形式化并将其编程到计算机中。这称为符号推理(symbolic reasoning)。

人们倾向于在他们的头脑中用一些规则来指导决策过程。例如,当医生诊断一个发烧的病人时,推断出这个病人体内可能有一些炎症。通过将大量规则应用于特定问题,医生可能能够得出最终诊断。

这种方法严重依赖于知识表示和推理。从人类专家那里提取知识可能是最困难的部分,因为在许多情况下,医生并不知道为什么他或她会得出特定的诊断。有时解决方案只是出现在他或她的脑海中,而无需明确的思考。有些任务,如从一张照片中确定一个人的年龄,根本无法归结为操纵知识。

自下而上的方法(Bottom-Up Approach)

或者,我们可以尝试模拟大脑中的最简单元素——一个神经元。我们可以在计算机中构建所谓的人工神经网络(Artificial Neural Network),然后尝试通过给出示例来教它解决问题。这个过程类似于新生儿如何通过观察了解周围的环境。

✅ 对婴儿的学习方式做一些研究。婴儿大脑的基本要素是什么?

什么是机器学习(Machine Leaning简称ML) 基于计算机学习以解决基于某些数据问题的人工智能的一部分称为机器学习(ML)。我们不会在本课程中考虑经典机器学习,推荐您参考单独的“机器学习初学者课程”。

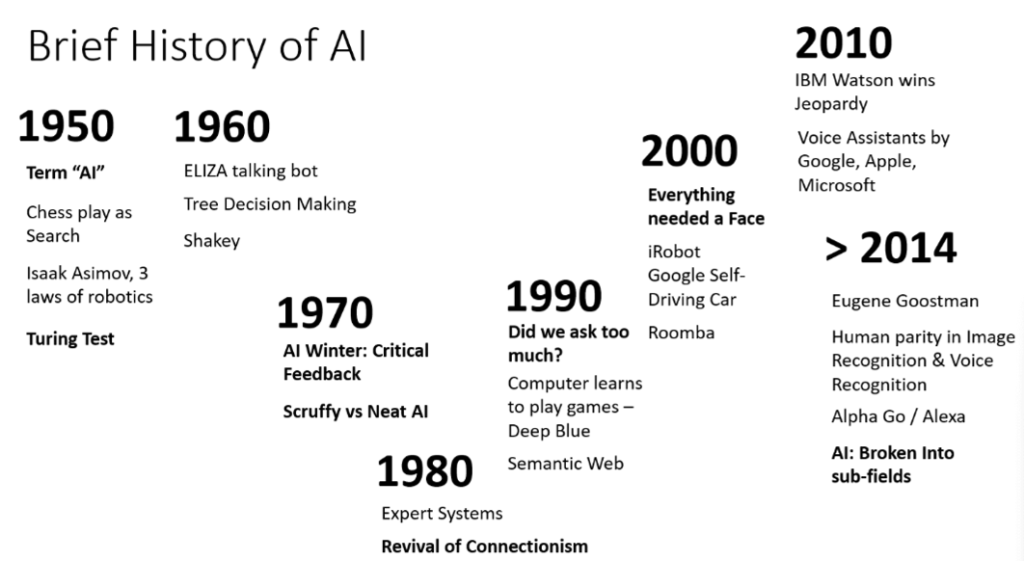

人工智能简史

人工智能是在20世纪中叶开始作为一个领域。最初,符号推理是一种流行的方法,它取得了一些重要的成功,例如:专家系统(Expert Systems)——能够在某些有限的问题领域中充当专家的计算机程序。然而,很快地便发现这种方法并不具有很好的扩展性。从专家那里提取知识,将其表示在计算机中,并保持该知识库的准确性,结果证明这是一个非常复杂的任务,而且在许多情况下成本太高,不切实际。这导致了20世纪70年代所谓的AI寒冬(AI Winter)。

图片由德米特里·索什尼科夫(Dmitry Soshnikov)提供

随着时间的推移,计算资源变得更便宜,更多的数据变得可用,所以神经网络方法(Neural Network Approaches)开始在与人类竞争的许多领域表现出色,例如:计算机视觉或语音理解。在过去的十年中,人工智能一词大多被用作神经网络(Neural Network)的同义词,因为我们听到大多数的AI都是基于神经网络。

我们可以观察到,例如,在创建下棋计算机程序的方法是如何改变的:

- 早期的国际象棋程序基于搜索,这个程序尝试预估对手在给定步数的下一步中可能走的棋子,并根据几步棋可以达到的最佳位置选择最佳走法。这导致了所谓的alpha-beta剪枝搜索算法(alpha-beta pruning search algorithm)的发展。

- 搜索策略在游戏结束时效果很好,因为搜索空间被少量可能的移动所限制。然而,在游戏开始时,搜索空间是巨大的,通过从人类玩家之间现有比赛中学习可以改进算法。随后的实验采用了所谓的基于案例的推理(Case-based reasoning),其中程序在知识库中寻找与游戏中当前位置非常相似的案例。

- 赢得人类玩家的现代程序基于神经网络和强化学习(Reinforcement learning),其中程序仅通过长时间与自己对弈并从自己的错误中吸取教训来学习下棋——这很像人类学习下棋时的做法。然而,计算机程序可以在更少的时间内玩更多的游戏,因此可以更快地学习。

✅ 对AI玩过的其他游戏做一些研究。

同样,我们可以看到创建“会说话的程序”(可能会通过图灵测试)的方法是如何改变的:

- 早期的此类程序,例如:Eliza(ELIZA 是 Joseph Weizenbaum 于 1964 年至 1967 年在麻省理工学院开发的早期自然语言处理计算机程序。),基于非常简单的语法规则,并将输入的句子重新表述为问题。

- 如今的AI助手,如Cortana、Siri或Google Assistant,都是混合系统,它们使用神经网络将语音转换为文本并识别我们的意图,然后采用一些推理或显式算法(Explicit Algorithms)来执行所需的操作。

- 未来,我们可以期待一个完全基于神经的模型(Neural-based model)自行处理对话。最近的GPT和Turing-NLG系列神经网络在这方面取得了巨大成功。

图片由德米特里·索什尼科夫(Dmitry Soshnikov)提供,照片由玛丽娜·阿布罗西莫娃(Marina Abrosimova)拍摄,Unsplash

目前的人工智能研究

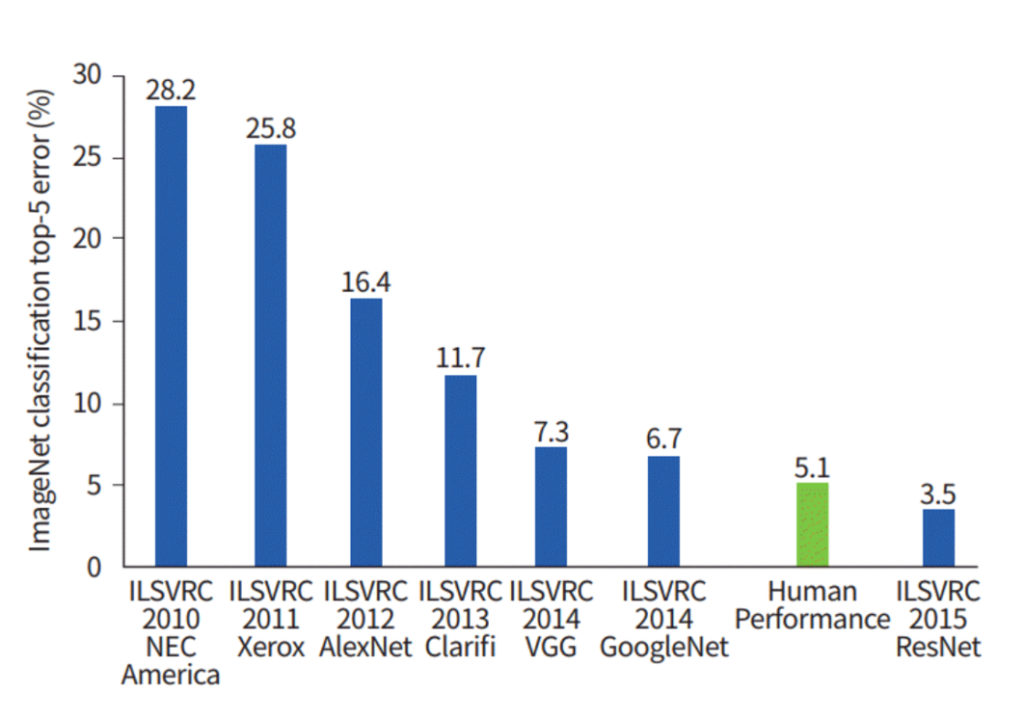

离我们最近的神经网络研究增长期在2010年左右,当时大型公共数据集开始可用。一个名为 ImageNet 的庞大图像集合,其中包含大约 1400 万张带注释的图像,催生出了 ImageNet 大规模视觉识别挑战赛 (ILSVRC)这是一项图像分类和定位任务的挑战赛。

图片由德米特里·索什尼科夫(Dmitry Soshnikov)提供

2012 年,卷积神经网络( Convolutional Neural Networks )首次用于图像分类,这导致分类错误明显下降(从近 30% 下降到 16.4%)。2015年,Microsoft Research的ResNet架构达到了人类水平的精度。

从那时起,神经网络在许多任务中都表现的出非常出色

| Year | 实现到达人类水平 |

|---|---|

| 2015 | 图像分类(Image Classification) |

| 2016 | 会话语音识别(Conversational Speech Recognition) |

| 2018 | 自动机器翻译(中译英)Automatic Machine Translation (Chinese-to-English) |

| 2020 | 图片说明(Image Captioning ) |

在过去的几年里,我们见证了大型语言模型(Large Language Models=LLM)的巨大成功,如BERT和GPT-3。这主要是因为有大量可用的通用文本数据,使我们能够训练模型来捕获文本的结构和含义,在通用文本集合上预先训练它们,然后将这些模型专门用于更具体的任务。在本课程的后面部分,我们将学习更多关于自然语言处理的信息。

🚀 一个挑战

浏览一下互联网,您认为人工智能在哪些方面得到最有效的应用。它是在地图应用程序中,还是在某些语音转文本服务或视频游戏中?来研究一下它们的系统是如何构建的。

复习与自学

通过阅读本课,回顾 AI 和 ML 的历史。从该课的草图笔记海报中选取一个元素,并对其进行更深入的研究,以了解影响其演变的文化背景。

-以上文章翻译自微软的AI-For-Beginners